|

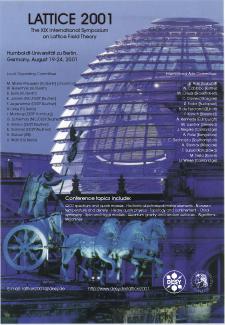

L A T T I C E 2 0 0 1Berlin, 19. - 24. August 2001 |

| Flyer | Poster |

Öffentliche Abendvorträge |

|

|

|

| (JPEG, 296k) | (JPEG, 115k) |

| For information: | Susanne Milde |

| Tel.: | 0331 - 7215371 |

| Fax: | 0331 - 7215380 |

| email: | milde@mildemarketing.de |

Lattice 2001: Particle Physics and Highest-End Computers

- the infinitely small world seen "on-screen"

International Conference on Particle Physics and Scientific Computing in Berlin for first time, 19. - 24. August 2001

Theoretical models of particle physics, matter in early stages of the universe, model simulations, the exciting development of highest-end computers and the necessary software to run them as well as the latest experimental results will be the topics of the international conference "Lattice 2001" taking place in Berlin for the first time.

We would like to invite you to a Press Conference on

Lattice 2001: Teilchenphysik auf Höchstleistungsrechnern - die Mikrowelt im Computer

Internationale Konferenz der Elementarteilchenphysik und des wissenschaftlichen Rechnens erstmalig in Berlin, 19. - 24.08.2001

Sie sind herzlich eingeladen zur Pressekonferenz am

Für Rückfragen stehe ich gern zur Verfügung:

Susanne Milde,

Tel.: 0331 - 7215371, Fax: 0331 - 7215380, email:

milde@mildemarketing.de

| 01(64k) | DESY am malerischen Zeuthener See. Eine Umgebung, die Inspiration aber auch Erholung für die Gitterphysiker bietet. |

| 02(43k) | Feste schrauben, damit die Maschine auch die schwierigsten Simulationen aushält. |

| 03(130k) | APEmille Maschinen im Rechenzentrum am DESY Zeuthen: massive Schränke, in denen die Simulationen zur Erforschung der Welt der Elementarteilchen stattfinden. |

| 04(152k) | Ein APEmille board, mit einem ihrer Rechenknoten (unten rechts im Bild)

und einem ihrer Kontrollprozessoren (oben rechts im Bild). Zum Grössenvergleich eine Datenfloppy. |

| 05(24k) | Der Weg von der normalen Materie unserer täglichen Umgebung bis zum Innersten eines Protons. Ob das Proton wirklich aus Quarks und Gluonen aufgebaut ist und wie diese zusammenwirken wollen die Gitterphysiker herausfinden. |

| 06(18k) | Zwei Leute (= Quarks) beim Austausch eines Balles (=Gluon). Durch das Zuspielen des Balles werden die Boote aktiviert - eine Wechselwirkung findet statt. Wie solch eine Wechselwirkung tatsächlich zwischen Elementarteilchen stattfindet simulieren die Gitterphysiker auf Supercomputern. |

| 07(161k) | Ein in Raum und Zeit lokalisiertes Objekt, wie die Physiker es in typischen Gittersimulationen finden. Die physikalische Interpretation dieser Objekte wird zur Zeit noch heftig debatiert. |

| 08(25k)

09(29k) 10(68k) 11(30k) | Was passiert, wenn Protonen sich überlappen? Es entsteht eine neue Art

von Materie - wie wir sie in der Frühphase des Universums vermuten. (Grafik mit freundlicher Genehmigung der GSI Darmstadt) |

| 12(303k) | Die Femtowelt unter dem "Computer-Mikroskop" Man erkennt, daß die statische Wechselwirkung zwischen Quark und Antiquark durch Ausbildung eines engen Flußschlauches erfolgt. Er verhindert, daß Quarks von Antiquarks isoliert werden können. |

| 13(51k) | Die Stromlinien magnetischer Monopole bilden geschlossene Schleifen in der vierdimensionalen euklidischen Gitterwelt der Quantenelektrodynamik. Zwar wurden magnetische Monopole in der klassischen Elektrodynamik bisher nicht entdeckt, jedoch können sie in der quantisierten Theorie als Feldfluktuationen in Erscheinung treten. |

Ziel der modernen Elementarteilchenphysik ist es, die kleinsten Bausteine unserer Welt zu identifizieren und ihr Zusammenspiel zu ergründen. Die theoretischen Teilchenphysiker entwickeln hierzu Modelle, die die ungewohnten und teilweise seltsamen Wechselwirkungen der Elementarteilchen beschreiben. So konnte unsere heutige Vorstellung von den Elementarteilchen und ihren Wechselwirkungen in Form eleganter, moderner Theorien entwickelt werden. Eine zentrale Theorie ist dabei die Quantenchromodynamik (QCD). Sie beschreibt die durch die Gluonen übermittelte starke Kraft und die Eigenschaften von Quarks sowie der aus ihnen aufgebauten Materie.

Die faszierende Welt der Elementarteilchen und ihre teilweise doch sehr erstaunlichen Eigenschaften, die sich vollständig unseren Alltagserfahrungen entziehen, bringen die etwa 400 Teilnehmer des Symposiums Lattice2001 aus allen Erdteilen nach Berlin. Die Phyiker wollen herausfinden, ob unsere theoretischen Modellvorstellungen tatsächlich die Physik der Elementarteilchen beschreibt, wie sie sich im Experiment zeigt. Dabei müssen sich die Forscher der Herausforderung stellen, dass herkömmliche Verfahren zur Berechnung der theoretischen Modelle vollständig versagen!

Daher greifen die Physiker u.a. auf eine ungewöhnliche Idee des Nobelpreistragers Kenneth G. Wilson zurück: unsere kontinuierliche Raum-Zeit wird einfach durch eine diskrete, körnige Gitter-Raum-Zeit-Struktur ersetzt. Dies erlaubt eine -sehr aufwendige- Computersimulation der Welt der Elementarteilchen. Anschliessend, muss dieser Trick allerdings wieder rückgängig gemacht werden, um den Kontakt zur normalen Welt wieder herzustellen. Diese Vorgehensweise ist Gegenstand der Gittereichtheorie, dem Gebiet der theoretischen Physik bei Lattice2001, und mit ihrer Hilfe ist es gelungen, viele fundamentale Fragen in unserem Verständnis des Mikrokosmos der Elementarteilchenphysik untersuchen zu können - Fragen, die mit anderen Methoden prinzipiell nicht beantwortet werden können.

Es ist nämlich heute vollständig unklar, ob die theoretisch vielfach geprüften und bestätigten Denkmodelle der Physik, wie das in den 1960er Jahren entwickelte Standardmodell der Elementarteilchenphysik, bei Abständen, die kleiner als 10-16 cm sind, noch die korrekte physikalische Beschreibung liefern. Die Physiker haben den Verdacht, dass sich bei kleineren Abständen eine völlig neue Physik zeigen könnte - eine Physik, die wir weder kennen, noch uns erträumen können.

Um aber diese neuen Strukturen überhaupt entdecken zu können, müssen die bestehenden Modelle auf den Prüfstand, indem wir sie besser und fundierter verstehen, um die vielen offenen Fragen beantworten zu können, die die Physiker heute plagen: Müssen die Quarks wirklich für alle Ewigkeit in den Hadronen eingeschlossen herumsausen ohne "Freigang"? Und was passiert eigentlich, wenn wir Kernmaterie so dicht zusammendrücken, dass sich die Kernbestandteile zu überschneiden beginnen? Diese Situation, wie wir sie am Anfang des Universums vermuten, wird heute im Experiment nachgestellt und die Gittereichtheorie ist in der Lage, hier bedeutende theoretische Vorhersagen zu machen.

In der Konstruktion theoretischer Modelle spielen Symmetrien eine wesentliche und entscheidende Rolle als Bauprinzip. Beispiele sind die CP und die chirale Symmetrie. Bei der CP Symmetrie tauscht man gleichzeitig Materie gegen Anti-Materie (C für charge=Ladung) aus und macht eine Raumspiegelung (P für Parität). Bei der chiralen Symmetrie tauscht man links- und rechts-händige Teilchen gegeneinander aus. Die fundamentalen Gleichungen der Physiker sind invariant gegenüber diesen Vertauschungen. Aber, in der Natur selber sind diese wichtigen Symmetrien offensichtlich verletzt, wie wir aus Experimenten wissen. Warum spielt uns die Natur diesen Streich? Warum respektiert die Natur nicht die eleganten Symmetriekonzepte, die sich die Theoretiker ausgedacht haben? Es ist den Physikern klar, dass Symmetrieverletzungen immens wichtig sind, um die Existenz des Universums und damit schliesslich unsere eigene verstehen zu können. Aber, wie hängt dies alles genau zusammen? Die Beantwortung dieser Fragen ist eine typische Herausforderung, der sich die Gitterphyiker stellen, wo sie bereits wichtige Resultate erzielt haben - und die nur durch ihre Methoden gemeistert werden kann.

Ein zentrales Problem der theoretischen Teilchenphysiker besteht dabei darin, die theoretischen Modelle quantitativ zu testen. Bis heute ist es eine der großen Herausforderungen, im Experiment gemessene Größen ausgehend von den Grundgleichungen der Theorie -und nur aus diesen- zu berechnen. Nur solche fundamentalen Rechnungen können Hinweise auf eine Physik jenseits unseres heutigen Verständnisses liefern.

Eine der erfolgreichsten Methoden, Theorie und Wirklichkeit zu vergleichen, ist die Simulation am Computer. Ähnlich wie bei Simulationen zum Flugverhalten eines Airbus, nur enorm viel komplizierter, kann so das Zusammenspiel der kleinsten Bausteine des Universums berechnet werden. Die aufwendigen Simulationen erlauben eine Konfrontation der theoretischen Modellvorstellungen mit experimentellen Ergebnissen - und damit einen Test, inwieweit bestehende Modelle tatsächlich die Physik beschreiben und wo sie erweitert werden müssen. Erst so finden Physiker die Schlupflöcher, an denen sich die antizpierte neue Physik bemerkbar macht.

Die zu lösenden Gleichungen sind allerdings so komplex, daß nur leistungsfähigste Supercomputer das Problem in den Griff bekommen können. Bis heute können die Theorien selbst mit den schnellsten, heute zur Verfügung stehenden Computern, noch nicht wirklich gelöst werden.

An dieser Stelle muß das althergebrachte Bild des ausschliesslich mit Papier und Bleistift, Tafel und Kreide arbeitenden Theoretischen Physikers revidiert werden. Auch Theoretische Physiker brauchen heute Maschinen: Höchstleistungscomputer, die in der Lage sind, extrem komplizierte Berechnungen durchzuführen. Sie werden derzeit – aus Kostengründen – von den Wissenschaftlern zum Teil selbst entworfen, entwickelt und gebaut.

In den USA werden solche Computer im Rahmen des QCDOC-Projektes (QCD On Chip) an der Columbia University in Zusammenarbeit mit IBM entwickelt. In Europa arbeiten Gruppen am DESY Zeuthen und am Istituto Nazionale di Fisica Nucleare (INFN) in Rom und Pisa sowie an der Université Paris-Sud um den den zukünftigen Supercomputer apeNEXT zu bauen. Weltweit gibt es zudem Bestrebungen, solche Höchstleistungsrechner in Form von PC-Clustern zu entwickeln.

Der Grund, dass die Physiker solche Rechnerarchitekturen verwenden können findet sich in der hohen Parallelisierbarkeit des zugrunde liegenden mathematischen Problems: jeder Prozessor bearbeitet nur einen kleinen Teil des gesamten Raum-Zeit-Gitters. Man benutzt also ein Gitter (von Prozessoren) in einem Gitter (von Raum-Zeitpunkten). Entscheidend ist nun, dass Daten nur zwischen benachbarten Prozessoren ausgetauscht werden müssen. Dies vereinfacht die Konzeption des Kommunikationsnetzwerkes und damit die Architektur der verwendeten Rechner erheblich. Darüber hinaus können die Prozessoren selber vereinfacht werden, da nur bestimmte mathematische Operationen häufig verwendet werden. Beide Aspekte fliessen in die Konstruktion der APE-Maschinen ein.

Bei derartigen Rechnungen kommt es u.a. darauf an, eine möglichst große Anzahl von Operationen mit Gleitkommazahlen durchzuführen. Das entscheidende Leistungskriterium der eingesetzten Rechner bemisst sich daher in "floating point operations per second" (Flops). Die aktuell erreichbare Rechenleistung von einigen Teraflops (dies sind 1.000.000.000.000 Flops) kann nicht von einem einzelnen Prozessor geleistet werden. Vielmehr müssen viele Prozessoren durch ein leistungsfähiges Netzwerk zusammengeschaltet werden. Und: Trotz ihrer hohen Komplexität müssen diese sogenannten massiv-parallelen Rechner im Dauerbetrieb über viele Wochen fehlerfrei arbeiten. Die Realisierung umfangreicher Rechnersysteme setzt die Skalierbarkeit der Architektur voraus. Dies bedeutet, dass die Addition weiterer Prozessoren zu keinen Verlusten in der Performance der verwendeten Programme führen. Für einen kostengünstigen Einsatz sind außerdem geringer Stromverbrauch und kompakte Bauweise wichtige Qualitätsmerkmale.

Um solche Rechner preisgünstig realisieren zu können, entwerfen, entwickeln und bauen die Physiker solche Maschinen selbst. Als Ergebnis entstehen Supercomputer, die für die Anwendungen in der Teilchenphysik eine Leistung erbringen, die der kommerzieller Spitzenprodukte (wie CRAY, Hitachi, IBM etc.) entsprechen - allerdings zu einem um den Faktor 10 geringeren Preis.

Um derartige Höchstleistungsrechner auch in Deutschland für die Forschung zur Verfügung zu stellen, beteiligt sich DESY Zeuthen an der Entwicklung von Parallelcomputern vom Typ APE ("Array Processor Experiment"). Sie sind Rechner speziell auf Anwendungen zugeschnitten, die Teilchenphysiker interessieren. Eingesetzt werden für die Anwendungen optimierte, selbstentwickelte Prozessoren, die durch ein schnelles und leistungsfähiges dreidimensionales Netzwerk zum Datenaustausch miteinander verbunden sind.

APEmille, der Nachfolger der APE100, wurde vom INFN unter Beteiligung von DESY entwickelt. Die Spitzenleistung dieser Maschinen liegt um einen Faktor 10 höher als bei APE100. Der Zugang zu den Prozessoren der APEmille ist durch ein Netzwerk von PCs realisiert, die mit dem Betriebssystem Linux ausgestattet sind. Diese PCs sind für das Laden der Programme, das Starten der Maschine sowie für die Ein- und Ausgabe von Daten zuständig.

Bis zum Sommer 2001 wurden an neun verschiedenen Standorten in Europa Höchstleistungsrechner vom Typ APEmille mit einer akkumulierten Spitzenleistung von insgesamt ca. 2 Teraflops installiert. Eine der größten Installationen stellt DESY im Rahmen des John von Neumann Instituts für Computing (NIC) am Standort DESY Zeuthen den Forschergruppen zur Verfügung. Dort sind vier Rechner mit etwa 900 Prozessoren rund um die Uhr in Betrieb.

Im Frühjahr 2001 haben das INFN, DESY sowie die Université Paris-Sud eine Kollaboration zur Entwicklung der nächsten Generation von APE-Rechnern gegründet. Ehrgeiziges Ziel dieses europäischen Projektes ist der Bau eines Prototyps mit ca. 400 Glop Rechenleitung bis Ende 2002. Eine einzelne Maschine vom Typ apeNEXT wird eine Spitzenleistung von etwa 2 Teraflops haben. Ein Reihe von Installationen derartiger Rechner soll dann den hohen Bedarf an Rechenzeit der europäischen Elementarteilchenforschung in diesem Bereich decken und genügt damit den Empfehlungen des ECFA (European Commitee for Future Accelerators) panels für "High Performance Computing", das den Rechenzeitbedarf in Europa für die nächsten Jahre evaluiert hatte.

Allerdings ist es schwierig, anhand von Modellen eine Theorie zu entwickeln, die den permanenten Einschluß der Quarks und die Struktur der Kernteilchen beschreibt, ohne gegen Gesetze der speziellen Relativitätstheorie und der Quantenmechanik zu verstoßen oder das Prinzip der Kausalität zu verletzen.

Nach jahrelanger Forschungsarbeit, experimentell wie theoretisch, vertrauen die meisten Teilchenphysiker heute darauf, daß sie die Wechselwirkungen zwischen den Quarks vollständig verstehen werden. Diese Zuversicht stützt sich vor allem darauf, daß die Theorie der Quark-Wechselwirkungen mathematisch ein Gegenstück zur erfolgreichsten physikalischen Theorie überhaupt ist: der Quantentheorie für die Wechselwirkungen im elektromagnetischen Feld, genannt Quantenelektrodynamik (QED). Die mathematische Ähnlichkeit der Theorie für die Quark-Wechselwirkungen mit der QED klingt auch im Namen an: Quantenchromodynamik (QCD).

Die komplizierte mathematische Struktur der QCD macht es enorm schwierig, exakte Voraussagen aus ihr abzuleiten. Die "Gitterphysiker" wenden nun mathematische Näherungsmethoden auf das Problem des Quark-Einschlusses an, indem sie die Raum-Zeit selber diskretisieren und so eine Gitterstruktur einführen. Dadurch lassen sich die mathematischen Probleme in der QCD in ein Programm giessen und auf einen Computer abbilden. Mit diesen numerischen Simulationen lassen sich dann die Voraussagen der QCD ausloten, indem man das jeweilige Problem näherungsweise löst und Folgen von immer besseren Näherungen bildet, also immer feinere Diskretisierungen wählt.

Den mathematischen Rahmen für diese Berechnungen bildet ein Konzept des Nobelpreisträgers Kenneth G. Wilson. Er hatte erstmals 1974 den Vorschlag gemacht, die QCD auf einem Gitter zu formulieren und anstelle des Raum-Zeit-Kontinuums nur diskrete Punkte zu betrachten. Ein sehr feines Gitter dieser Art ist natürlich allenfalls eine Näherung für das Raum-Zeit-Kontinuum, aber es ermöglicht Rechnungen, die auf anderem Wege nicht durchführbar wären.

Werden die Maschen des Gitters immer enger gewählt, nähern sich die physikalischen Grössen denjenigen der Theorie mit kontinuierlichen Raum- und Zeitachsen an. Erst dann können die Physiker einen Vergleich mit dem Experiment anstellen -- und damit den gewünschten Test der Theorie durchführen.

Viele physikalisch interessante Grössen konnten so numerisch berechnet werden. So konnten die fundamentalen Parameter der Theorie wie die Stärke der Kopplungskonstanten oder die Massen der Quarks und der aus diesen zusammengesetzten Hadronen bestimmt werden. Zudem sind viele Grössen wie die, für die Interpretation relevanter Zerfallsmatrixelemente, heute schon den Gittermethoden zugänglich.

Aber das Spektrum der Gittereichthorie ist sehr viel breiter:mit Hilfe der von den Gitterphysikern entwickelten Methoden können kosmologische Phasenübergänge im Computer simuliert werden, wie sie in der Frühphase des Universums stattgefunden haben sollen.

Materie unter extremen Bedingungen, wie sie früh im Universum oder an den Experimenten am CERN oder Brookhaven auftreten, sind Fragen, wo die Gittereichtheorie wichtige Beitrage geliefert hat. Untersuchungen der mathematischen Struktur der Theorien selbst oder Entwicklung von effizienten Algorithmen sind ebenso Teilgebiete der Gittereichtheorie, wie Studien des mysteriösen Higgsteilchens. Die Liste der "topics", mit denen sich die Gitterphysiker bschäftigen, ist noch sehr lang und alle Aspekte werden in der Konferenz Lattice 2001 in Berlin behandelt werden.

Viele relevante Grössen, wie oben beschrieben, sind bereits in der Gittereichtheorie berechnet worden. Die Gitterkonferenz in Berlin wird darüber einen exzellenten Überblick geben. Das breite Spektrum der "topics" auf der Konferenz zeigt, dass die Gittermethode in immer weitere Bereiche der Physik eingreift und in der Lage ist, wichtige Beiträge zu liefern. Es gibt allerdings auch widerspenstige physikalische Phänomene, für die die bisher angewandte Näherungsmethode in der Gittereichtheorie oft noch nicht fein genug ist, als dass die Ergebnisse die von den Gitterphysikern geforderte Präzision haben. Ein Beispiel sind Fragestellungen, die mit der sehr wichtigen "chiralen Symmetrie" (der Symmetrie zwischen rechtshändigen und linkshändigen Elementarteilchen) vernüpft sind. Die Physiker arbeiten deshalb intensiv daran, ihre Näherungen kontinuierlich zu verbessern. Dies geht Hand in Hand mit einer ebensolchen kontinuierlichen Verbesserung der Rechenleistung, so dass die Physiker eines Tages tatsächlich in der Lage sein werden bei Lattice2010 (Lattice2020?) die "Lösung" der QCD präsentieren zu können.